PCIe-kaart vermindert energieverbruik in AI-servers aanzienlijk

Tijdens CES 2024 introduceerty het Koreaanse DEEPX de DX-H1. Dit is een PCIe-kaart die is ontworpen om de prestaties van AI-servers te versnellen en tegelijkertijd het energieverbruik te verlagen. De DX-H1, die in aanloop naar de beurs in Las Vegas de CES 2024 Innovatie Award heeft gewonnen in de categorie Computer Hardware en Componenten, legt de nadruk op prestaties, energie-efficiëntie en kosteneffectiviteit.

De PCIe-versnellerkaart biedt een uitzonderlijke energie/prestatie-efficiëntie die de huidige GPU-gebaseerde oplossingen met meer dan 10 keer overtreft. Hierdoor kan deze kaart wellicht een significante rol gaan spelen in het verminderen van koolstofemissies voor AI-servers en datacenters.

De markt voor AI-servers is afhankelijk van energie-intensieve GPU's, waarvan het hoge energieverbruik leidt tot aanzienlijke koolstofemissies. De noodzaak om de milieueffecten te minimaliseren en de efficiëntie te verhogen, met name in datacenters, stimuleert de vraag naar duurzamere, energiezuinige AI-accelerators. Analisten verwachten dan ook dat deze markt snel zal gaan groeien. Uit projecties van TrendForce blijkt bijvoorbeeld dat de markt voor AI-servers zal groeien met een samengestelde jaarlijkse groei (CAGR) van meer dan 36% tot 2027. Voor datacenters die tegelijkertijd koolstofemissies willen beperken en een competitief voordeel willen behalen door AI-prestaties van topniveau mogelijk te maken, vertegenwoordigen producten zoals de DX-H1 een mogelijke oplossing.

DEEPX heeft twee nieuwe technologieën ontwikkeld. Dat is allereerst IQ8. Dit is een manier om AI-modellen te comprimeren, waardoor dataverwerking als het trainen van modellen sneller kan gebeuren. Smart Memory Access minimaliseert het gebruik van D-RAM tot minder dan een tiende van de typische GPU-niveaus, wat met name gunstig is voor inferentie-workloads.

De DX-H1 integreert ook met bestaande GPU’sen biedt een interface om door GPU’s getrainde AI-modellen te ondersteunen. Dit maakt een overgang mogelijk voor bedrijven die de prestaties willen verbeteren zonder de noodzaak van systeemwijzigingen.

Meer over

Lees ook

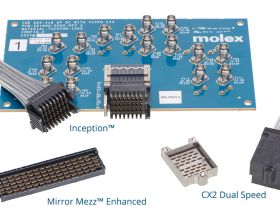

Eerste chip-naar-chip 224G-interconnect voor high-performance computing in datacenters geïntroduceerd

De nieuwe interconnect omvat een nieuwe generatie bekabeling, backplanes, board-to-board-connectoren en near-ASIC connector-naar-kabeloplossingen die werken met snelheden tot 224 Gbps-PAM4. Om dit soort snelheden te realiseren was een nieuwe systeemarchitectuur nodig met meerdere chip-naar-chip-verbindingensschema’s.

Amerikaanse overheid steekt 40 miljoen dollar in liquid cooling

In de Verenigde Staten heeft de federale overheid voor een bedrag van 40 miljoen dollar subsidies verleend aan bedrijven en universiteiten die nader onderzoek willen doen aan liquid cooling. In totaal zijn vijftien leveranciers en universitaire laboratoria geselecteerd om de eerste stappen te zetten onder COOLERCHIPS, een programma om het stroomve1

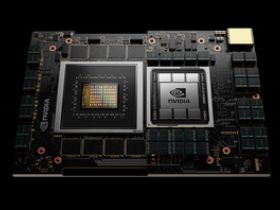

Gelekte slide van Nvidia laat datacenter-chips zien die tot wel 1000 Watt gebruiken

De volgende generatie datacenter-processoren van AMD, Intel en Nvidia zal 500 tot 1000W aan stroom verbruiken, zo blijkt uit een naar verluid uitgelekte dia van een Gigabyte-roadmap die is gepubliceerd door de gerenommeerde hardware-leaker HXL. Het zal een serieuze inspanning vergen om deze CPU's en GPU's te koelen. En dat probleem gaat al spelen1