Hoe gaat AI de datacentermarkt veranderen?

ChatGPT heeft sinds november 2022 een revolutie op het gebied van kunstmatige intelligentie (AI) veroorzaakt, die elke markt transformeert en de manier waarop we werken gaat veranderen. AI biedt onder andere mogelijkheden om de efficiëntie en productiviteit van bedrijfsprocessen te verbeteren, medisch onderzoek te versnellen en creatieve ideeën sneller uit te werken. PWC verwacht dat AI in 2030 15,7 biljoen dollar zal bijdragen aan de wereldeconomie.

AI wordt meestal onderverdeeld in twee categorieën: generatief en voorspellend. Generatieve (GenAI) gebruikt bestaande data als basis om nieuwe originele inhoud te creëren, zoals chats, teksten, afbeeldingen of nieuwe producten. Voorspellende AI wordt, zoals de naam al aangeeft, gebruikt om voorspellingen te doen op basis van datatrends om de besluitvorming te verbeteren. GenAI wordt vaak gebruikt in marketing, design en medisch onderzoek, terwijl voorspellende AI vooral wordt toegepast voor marktanalyses, financiële diensten en preventief onderhoud.

Hoewel datacenters natuurlijk vooral AI-apparatuur huisvesten, kunnen ze zelf ook profiteren van deze krachtige systemen. De geavanceerde algoritmen en machine learning-mogelijkheden van voorspellende AI kunnen enorme hoeveelheden data in realtime analyseren, met als doel datacenters intelligenter en adaptiever te maken. Ze kunnen potentiële problemen signaleren en daarop anticiperen voordat die zich voordoen. Met als resultaat een nog betere beschikbaarheid en betrouwbaarheid, wat datacenterklanten natuurlijk waarderen.

Nieuwe GPU's stuwen AI-groei en veranderingen

Ik heb onlangs NVIDIA GTC en OFC in maart en DC World in april bijgewoond. Op deze events was veel nieuws te horen en AI domineerde de meeste gesprekken. NVIDIA GTC gaf een goed beeld van de nieuwste en krachtigste GPU-technologie, OFC introduceerde het nieuwste op het gebied van hogesnelheidsnetwerken en DC World gaf een vooruitblik op hoe dit alles de eisen ten aanzien van datacenters gaat beïnvloeden.

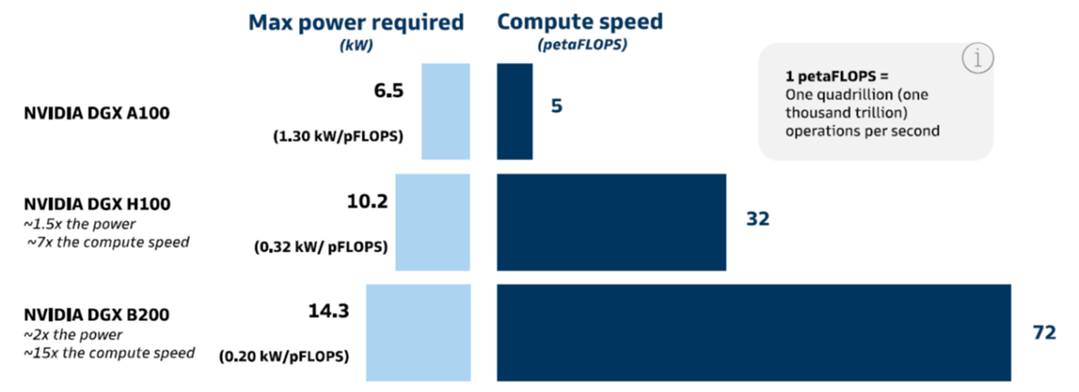

Na enkele jaren tweejaarlijks een nieuwe GPU te hebben geïntroduceerd, deed NVIDIA dat in 2024 alweer met de nieuwe Blackwell-processor, die aanzienlijk beter is dan zijn voorgangers. De onderstaande afbeelding toont zowel de toename van het vermogen als de toename van de rekensnelheid voor drie verschillende NVIDIA-servers met elk 8 GPU's.

Hoewel het enige tijd kan duren voordat er producten met Blackwell op de markt verschijnen, heeft het datacenterbedrijven al inzicht gegeven in de infrastructuur die ze nodig zullen hebben. Een volledig rack van vier DGX B200's heeft 60 kW nodig, maar de duurdere NVL72 SuperPod die gebruikmaakt van de GB200 Superchip gaat zelfs 120 kW verbruiken en vereist direct-to-chip vloeistofkoeling. NVIDIA kondigde ook aan dat hun volgende GPU genaamd Rubin, die mogelijk in 2026 zal verschijnen, ontworpen zal zijn om de energie-efficiëntie te optimaliseren.

Bij DC World verklaarde Ali Fenn, president van Lancium, dat “AI de grootste kapitaalinvestering in de geschiedenis zal zijn” en merkte op dat het stroomaanbod, meer dan de GPU-technologie, gaat bepalen hoe snel AI kan groeien. Er waren al zorgen over de stroomvoorziening vóór de komst van AI, toen een gemiddeld rack slechts 10 kW nodig had, maar het heeft een veel groter gevoel van urgentie gekregen nu racks misschien wel twaalf keer meer vermogen nodig hebben.

In 2025 zal 10% van alle datacenterstroom worden gebruikt voor AI (bron: New York Times). De toename van het aantal AI-systemen in datacenters en het hogere stroomverbruik per rack versnelt de behoefte aan vloeistofkoeling. Dit was al te zien op de beursvloer van DC World, waar meer dan tien bedrijven voor vloeistofkoeling aanwezig waren, waaronder veel startups die nog geen twee jaar oud zijn. Hoewel de meningen verschillen over wanneer vloeistofkoeling nodig is, wordt algemeen aangenomen dat dit moet worden toegepast als het rackvermogen groter is dan 40 kW. Het toevoegen van vloeistofkoelingsystemen aan een bestaand datacenter is niet triviaal en een manager vertelde dat hij zijn team verwachtte uit te breiden met meerdere loodgieters.

Om GPU’s onderling te verbinden voor een cluster (of pod) dat nodig is voor grootschalige AI, zijn glasvezelkabels en snelle optische transceivers vereist. Met maximaal 8 GPU's per server die elk draaien op datasnelheden tot 800G zullen veel datacenters een viervoudige toename van het aantal glasvezelkabels zien. Dit draagt op zijn beurt bij aan de congestie in de bekabelingstoevoer en leidt tot de behoefte aan bredere goten, zoals 24” of 36” breedtes en meerdere lagen als de ruimte boven het plafond dit toelaat.

Datacenters moeten tevens worden ontworpen met het oog op schaalbaarheid en flexibiliteit om AI-workloads aan te kunnen. Hogesnelheidsnetwerken met een lage latency zijn cruciaal voor een efficiënte AI-dataverwerking, in combinatie met robuuste opslagsystemen en nieuwe technieken voor datamanagement. Datacenterexploitanten komen ook onder nog meer druk te staan om de milieuimpact van hun activiteiten te beperken en zoveel mogelijk duurzame energie te gebruiken. Door de beperkingen van elektriciteitsnetten in grote delen van de wereld, krijgt zelfs kernenergie serieuze aandacht als een manier om de ecologische voetafdruk te verkleinen en meer energie toe te voegen. Schaalbaarheid, flexibiliteit, veiligheid en duurzaamheid zijn essentiële factoren waarmee men rekening moet houden bij het ontwerpen en exploiteren van AI-datacenters.

Veranderende eisen vragen om nieuwe AI-datacenters

AI beïnvloedt alle markten, maar het is niet overdreven om te zeggen dat datacenterbedrijven de grootste impact gaan voelen. De combinatie van al deze veranderingen in eisen heeft veel van hen ervan overtuigd dat het achteraf inrichten van bestaande datacenters niet altijd haalbaar is. Er zullen dus ook nieuwe faciliteiten moeten worden gebouwd in gebieden met overvloedige en goedkope energie. Deze nieuwe AI-datacenters zullen speciaal worden gebouwd met vloeibare koeloplossingen, bredere kabelgoten en zelfs dikkere betonnen vloeren die nodig zijn om de zwaardere AI-apparatuur te huisvesten.

Ondanks de onmiskenbare voordelen van AI brengt de transitie die nodig is om AI in datacenters te implementeren veel uitdagingen met zich mee, namelijk

- Meer stroom en rekenkracht om de snel groeiende hoeveelheid data te verwerken

- Innovatieve koelsystemen voor krachtigere GPU’s, servers en switches

- Tot 4x zoveel glasvezels om de servers en switches met elkaar te verbinden

- Grotere bovengrondse kabelgoten

- Ontwerpen die de flexibiliteit bieden om capaciteit toe te voegen zonder bestaande bekabelingsnetwerken te verstoren

- Duurzaamheidsverbeteringen

Samengevat moeten datacentereigenaren en -exploitanten meer van alles aankunnen: meer glasvezelkabels, meer gootruimte, meer warmte verwerken en nog belangrijker, meer stroom. Ondanks deze uitdagingen is het een opwindende tijd om in de datacentermarkt te werken, omdat het aantal projecten op een recordhoogte staat en de vraag nog steeds niet is bij te houden.

Bij Panduit hanteren we een klantgerichte aanpak van de AI-revolutie, met de betrokkenheid en verantwoordelijkheid om een vertrouwde adviseur voor onze klanten te zijn tijdens hun AI-reis. We zijn vastbesloten om voorop te blijven lopen in deze AI-revolutie en klanten de innovatieve oplossingen en expertise te bieden die ze nodig hebben om succesvol te blijven groeien in het zich snel ontwikkelende datacenterlandschap.

Dit artikel en de bijbehorende infographic geven een inzicht in de toekomstige transformaties van datacenters. Het is de eerste van op AI gerichte blogs die datacentereigenaren kunnen helpen bij de voorbereidingen die nodig zijn voor het bouwen van een generatieve AI-infrastructuur. Via onze website kunnen geïnteresseerden op de hoogte blijven van meer informatie over AI-datacenters.

Bob Wagner is senior business development manager datacenters bij Panduit

Meer over

Lees ook

Gezamenlijke aanpak voor energiebesparing servers Omgevingsdiensten en datacenters

Vertegenwoordigers uit de datacenterbranche hebben met de omgevingsdiensten een belangrijke samenwerking afgesproken. Doel is om het energieverbruik van servers te verlagen. De ondertekening vond plaats op Nationale Energiedag tijdens het EZK Energie Event in Hilversum. De maatregel belooft een energiebesparing die groter is dan de opbrengst van e1

Vliegverkeer Genève gestremd door wateroverlast in datacenter

Dinsdagavond heeft de luchthaven van Genève twee uur lang geen vluchten verwerkt door wateroverlast. Zware regen zorgde niet alleen voor natte landingsbanen, een deel van het datacenter van de verkeersleiding liep onder.

‘Microsoft stopt met Project Natick voor datacenters onder water’

Dat meldt de website Tom’s Hardware. Project Natick ging in 2013 van start. De website meldt dat het bedrijf deze beslissing heeft bevestigd aan DatacenterDynamics. Noelle Walsh, hoofd van Microsoft’s Cloud Operations + Innovation, verklaarde: "Ik bouw nergens ter wereld onderzeese datacenters."