Nieuwe Intel-processor helpt datacenters Big Data te ondersteunen

Al geruime tijd zien we in de IT-laag van het datacenter een belangrijke trend. Waar we vroeger vooral servers zagen die allemaal een min of meer identieke architectuur kenden, hebben we tegenwoordig steeds meer maken met hardware die geoptimaliseerd is voor specifieke toepassingen. Daardoor zien we nu bijvoorbeeld allerlei servers opduiken die gebaseerd zijn op chips die voorheen vooral voor mobiele devices bedoeld waren. Deze IT-hardware is daardoor wellicht niet geschikt voor het zware rekenwerk, maar voor relatief lichte toepassingen voldoen deze systemen uitstekend. Een niet onbelangrijk voordeel: het energiegebruik van dit soort processoren is geoptimaliseerd voor mobiele apparaten en is dus over het algemeen zeer klein. Ook de kosten voor energie vallen hierdoor zeer bescheiden uit.

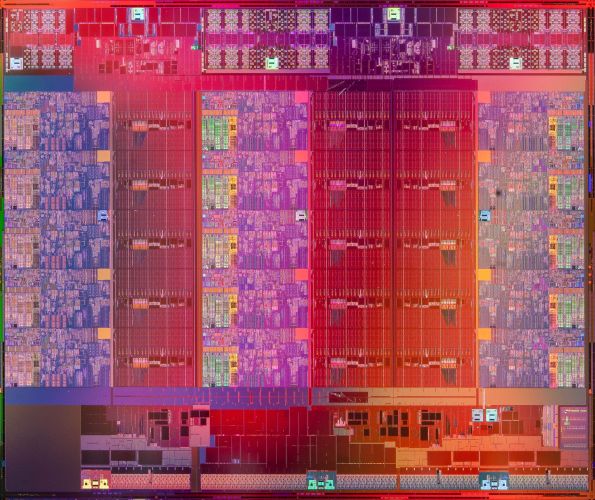

Vijftien cores

We zien deze beweging echter niet alleen aan - zeg maar - de onderkant van de servermarkt. Ook voor het zware rekenwerk zien we nieuwe en gespecialiseerde architecturen opkomen. Intel lanceerde onlangs bijvoorbeeld een nieuwe processor-familie die juist aan die andere kant van het spectrum thuishoort. De Xeon-familie E7 v2 is namelijk bedoeld voor zware IT-applicaties waarbij zeer grote hoeveelheden gegevens niet alleen heel snel, maar vooral ook allemaal tegelijkertijd voor verwerking in het werkgeheugen van de server geladen moeten kunnen worden. Dit wordt ook wel ‘in-memory computing’ genoemd. Deze manier van gegevens verwerken is vooral van toepassing bij belangrijke trends als Big Data, business analytics en Internet of Things. Bij dit soort toepassingen worden grote hoeveelheden en vaak ook zeer diverse soorten en typen gegevens verwerkt en geanalyseerd.

Intel heeft alles uit de kast gehaald om van de Xeon E7 v2 een processor-familie te maken waarvan de specificaties bij uitstek geschikt zijn voor dit type IT-toepassingen. De processor komt in meerdere varianten waarbij 6 of 12 Terabyte aan data tegelijkertijd door de cpu’s of cores van de chip kunnen worden verwerkt. De processor is dus in staat om zeer grote hoeveelheden data in één keer te verwerken en te analyseren, een vereiste bij toepassingen als Big Data en Internet of Things.

De processor telt maximaal 15 vijftien cores of rekenkernen. Per server kunnen twee, vier of acht van deze chips met 15 cores worden toegepast. Daarmee is dus standaard reeds een zeer grote rekencapaciteit beschikbaar. Sommige fabrikanten hebben echter besloten om servers te ontwikkelen die meer dan acht processoren tellen. Om dit te realiseren heeft Intel een speciale externe koppelingsmethode ontwikkeld. waardoor nog meer processoren met elkaar verbonden kunnen worden. Hierdoor ontstaan gespecialiseerde systemen die bij uitstek geschikt zijn voor het razendsnel verwerken van zeer grote hoeveelheden data.

Rekencapaciteit

Bij applicaties op het gebied van Big Data en Internet of Things is echter meer nodig dan enkel en alleen een groot werkgeheugen en processoren die veel rekencapaciteit te bieden hebben. Servers die voor dit soort toepassingen zijn bedoeld, dienen eerst en vooral in balans te zijn. Anders gezegd: de gehele architectuur van een dergelijke server zal afgestemd moeten zijn op dit soort rekenintensieve toepassingen. Met name het cache-geheugen - een soort tussengeheugen tussen werkgeheugen en het externe geheugen - speelt hierbij een belangrijke rol. Intel heeft het cache-geheugen ten opzichte van de eerste generatie E7-processoren met meer dan vijfentwintig procent vergroot. Hiermee wil Intel voorkomen dat er zich tussen schijfgeheugen en werkgeheugen van de server bottlenecks gaan voordoen, waardoor de processor als het ware moet wachten totdat er nieuw te verwerken data is aangevoerd. Bovendien is het maximum aantal threads ofwel het aantal rekenacties dat gelijktijdig kan worden uitgevoerd vergroot met de helft.

Interessant aan deze processor-familie is verder dat deze op twee verschillende manieren kan functioneren. In de zogeheten ‘performance mode’ is de processor zodanig geconfigureerd dat maximale input en output van data mogelijk is. In de ‘lockstep mode’ daarentegen is de focus iets minder gericht op piekprestaties, maar wordt juist weer meer aandacht besteed aan de betrouwbaarheid van de gegevensverwerking en de transacties die plaatsvinden.

Andere noviteiten die Intel heeft toegepast komen in de vorm van wat in jargon wel ‘RAS’ wordt genoemd. RAS staat voor ‘reliability’, ‘availability’ en ‘security’. Hieronder vallen tal van nieuwe features die het mogelijk maken dat op deze processor gebaseerde servers een beschikbaarheid kunnen halen van 99,999 procent. Ook is veel aandacht besteed aan gegevensbeveiliging. Wie met Big Data en dergelijke aan de slag gaat, werkt in de regel met zeer gevoelige bedrijfsgegevens. Data-integriteit is dan zeer belangrijk. Intel heeft hiervoor een aantal nieuwe voorzieningen ontwikkeld.

Power en koeling

De Xeon E7 v2 is een nieuw voorbeeld van een trend richting specialisatie van IT-hardware. De tijd dat voor zo’n beetje iedere applicatie en iedere taak in het datacenter een ‘general purpose’ server werd toegepast, is duidelijk voorbij. IT-afdelingen kijken tegenwoordig steeds beter naar het type applicatie dat zij willen ‘draaien’ en kiezen hierbij de hardware die het meest voor deze toepassing geschikt is. Soms overheerst daarbij - zoals bij de Xeon E7 v2 - de behoefte aan brute rekenkracht en de beschikbaarheid van zeer grote werkgeheugens, in andere gevallen is de ‘IT workload’ relatief licht en voldoen processoren van een lichter kaliber.

Voor een datacenter manager betekent deze trend vooral dat de voorheen redelijk eenvoudig vast te stellen profielen voor power en koeling nu steeds meer maatwerk worden. Per rack zal heel goed gekeken moeten worden naar het type hardware dat de IT-afdeling wil plaatsen. De behoefte aan bijvoorbeeld koeling binnen het rack kan namelijk totaal verschillen - afhankelijk van de toepassing. Hetzelfde geldt voor de behoefte aan energie. Tools voor asset management zijn veelal in staat dit soort gegevens over de IT-hardware in te lezen. Is voorzien in een goede koppeling in twee richting tussen het DCIM-pakket en de software voor IT asset management, dan beschikt het datacenter over nauwkeurige info over dit soort onderwerpen. Het wordt hierbij de komende tijd interessant om te zien hoe deze behoefte aan power en koeling in de tijd gaat variëren. Slagen de business-klanten van de betrokken IT-afdeling er in dit soort systemen volledig vol te plannen met Big Data-achtige applicaties? Of gaan we grote wisselingen zien in de belasting van dit soort servers. Deze vraag maakt de koppeling tussen DCIM en IT asset management nog eens extra belangrijk. Een datacenter manager die niet over een dergelijke koppeling beschikt, heeft er namelijk nog een nieuw probleem bij. Hij zal met de hand dit soort gegevens moeten verzamelen en zijn power- en koelingsprofielen ook met de hand moeten bijstellen.

Robbert Hoeffnagel