SDDC vereist integratie van IT en infra

Op de IT-laag van het datacenter vinden grote veranderingen plaats. Ontwikkelingen die een duidelijke impact hebben op de technische infrastructuur van datacenters. Met name de opkomst van Software Defined Data Centers (SDDC) speelt hierbij een hoofdrol. Maar wat is dat? En wat zijn de gevolgen hiervan voor de infrastructuurlaag van het datacenter?

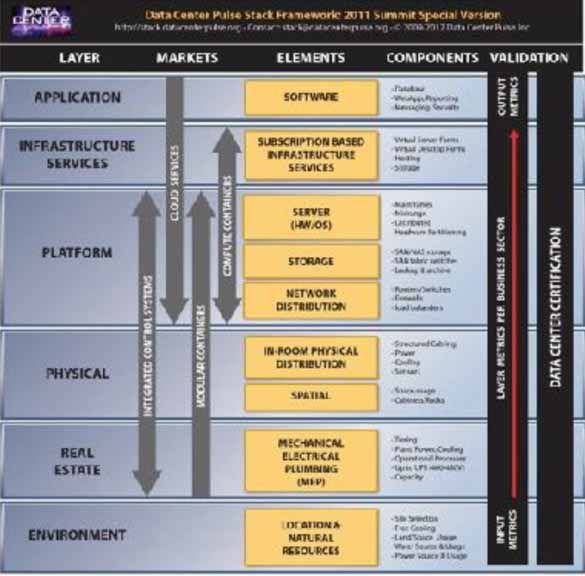

Een Software Defined Data Center wijkt op een aantal essentiële punten af van de traditionele manier van werken. Om dit duidelijk te maken is het verstandig om even een stap terug te doen. Waar dient een datacenter nu eigenlijk voor? We kunnen hiervoor een schema gebruiken dat een vergelijkbare opbouw kent als het bekende OSI-model (figuur 1).

We zijn gewend om zo’n model van onder naar boven te lezen, al is dat eigenlijk een vreemde gewoonte. Het uiteindelijke doel is immers het mogelijk maken van de bovenste laag. Het schema in figuur 1 is een aantal jaren geleden gemaakt door Datacenterpulse, een organisatie die inmiddels niet meer bestaat. Eigenlijk dient er bovenop de bovenste laag nog een laag getekend te worden waarin de business processen van de klant van het datacenter een plaats hebben. Want daar gaat het uiteindelijk allemaal om. Die klant verkoopt bier of verzekeringen of auto’s en dat is de kern van de organisatie. Applicaties, servers, switches zijn enkel en alleen bedoeld om deze business processen te faciliteren. En de technische of fysieke infralaag met zijn racks, power, koeling en dergelijke is weer bedoeld om het ‘draaien’ van applicaties via de IT-hardware te ondersteunen.

Klassiek datacenter

In een klassiek opgezet datacenter installeert de IT-afdeling applicaties op servers, waarbij de data op storage-apparaten wordt vastgelegd. Via een netwerkinfrastructuur wordt deze data beschikbaar gemaakt voor andere applicaties en software, maar uiteraard ook voor de gebruikers in de business-organisatie. Hetzelfde geldt voor de toegang tot applicaties. Die infrastructuur bestaat - zoals we zien in figuur 1 - uit een IT-infrastructuur en een fysieke infralaag. En maakt - zoals de lagen daaronder aangeven - gebruik van een gebouw ofwel real estate.

Hoe vreemd het wellicht ook klinkt, maar in veel datacenters is de infrastructuur in redelijke mate bepalend. Denk maar eens aan het bekende feit dat op iedere Windows-server slechts één applicatie is geïnstalleerd. En net als de fysieke verbindingen die we met kabels leggen tussen apparaten in klassieke datacenters gelijk staan aan de dataverbinding die van deze kabels gebruik maakt. Een kabel die van een poort op een switch naar een ethernet-poort op een server loopt, kan enkel data tussen die twee poorten transporteren. Wie de data niet naar die ene server wil hebben, maar naar - bijvoorbeeld - een storage-apparaat dient daar een nieuwe dedicated kabelverbinding voor aan te leggen.

Die aanpak voldoet niet meer. De redenen daarvoor zijn ook meer dan overtuigend. Zo’n klassieke aanpak is namelijk zeer star. Een kabel loopt van A naar B en daarmee is dus ook een dataverbinding gecreëerd die van A naar B loopt. B door C vervangen kan natuurlijk wel, maar dan dient er een nieuwe kabel getrokken te worden. Een verandering doorvoeren kost dus tijd. Met andere woorden, we kunnen op deze manier niet of nauwelijks voldoen aan de veel gehoorde wens van de business dat IT sneller en flexibeler moet reageren op veranderingen in de zakelijke markt waarin de business actief is. Hetzelfde geldt voor servers en storage. Voor iedere nieuwe applicatie is een nieuwe server nodig. Storage-apparaten kunnen wel gedeeld worden, maar daar zitten behoorlijke beperkingen aan.

Softwarematig instellen

Dit kan beter. En wel door aan de slag te gaan met een concept genaamd: Software Defined Data Center ofwel SDDC. In feite is dit een aanpak waarbij de functionaliteit die het datacenter aan zijn afnemers biedt softwarematig kan worden ingesteld. Als dat te abstract klinkt, kijk dan eens naar dit voorbeeld. De IT-afdeling heeft nieuwe servercapaciteit nodig. Waar we voorheen in zo’n geval een nieuw apparaat in een rack dienden te plaatsen en aan te sluiten, geven we bij een SDDC in een managementconsole aan dat we een server nodig hebben en aan welke specificaties deze moet voldoen. Vervolgens wordt softwarematig extra servercapaciteit beschikbaar gesteld.

Als dit als een bekend concept klinkt, dan heeft u gelijk. Dit is immers het idee achter servervirtualisatie. Anders gezegd: virtual machines. Virtualisatie maakt dan ook deel uit van het concept SDDC. Deze kent namelijk drie hoofdcomponenten: compute, storage en networking. Compute ofwel servercapaciteit is hierbij een functie en niet een apparaat. Hetzelfde geldt voor storage en networking. Apparaten en functies worden hierbij dus compleet van elkaar gescheiden.

Servervirtualisatie

Hoe dit gerealiseerd wordt, kunnen we het beste uitleggen aan de hand van het bekende fenomeen van servervirtualisatie. De IT-afdeling schaft hierbij een grote server aan. Hoe meer processor- en geheugencapaciteit hoe beter. Op deze server wordt software geïnstalleerd die de hardware van de server afschermt van de applicaties. De applicatie ‘praat’ dus niet rechtstreeks met de hardware zoals het geval is bij klassieke servers, maar tegen software die zich voordoet als server. Een virtuele server dus.

Heeft de IT-afdeling nu een server nodig voor een bepaalde applicatie, dan creëert de virtualisatiesoftware een softwarematige ofwel virtuele server met de specificaties die de IT-afdeling opgeeft. Welk type processor is nodig, hoeveel werkgeheugen, welke netwerkverbindingen, noem maar op. Vervolgens kan de IT-afdeling de applicaties op deze (virtuele) server installeren. Voor de applicatie ziet die softwarematige server er exact hetzelfde uit als een hardwarematige server. De applicatiesoftware hoeft dus niet aangepast te worden. Alles werkt alsof het om echte hardware gaat. In werkelijkheid worden echter alle taken en commando’s - bijvoorbeeld om data naar een storage-apparaat te schrijven of het printen van een bestand te regelen - door de virtualisatiesoftware opgevangen en vertaalt naar functies waar de fysieke hardware iets mee kan.

Op een vergelijkbare manier werkt virtualisatie ten aanzien van storage en networking.

Stel nu dat de IT-afdeling de virtuele server wat te klein heeft gemaakt. Er is bijvoorbeeld meer werkgeheugen nodig om de applicatie sneller te laten functioneren. Dan kan men dit simpelweg via de eerder genoemde managementconsole aanpassen. De virtualisatiesoftware voert de wijziging door en past de virtual machine aan. De gebruiker hoeft niets te doen, maar merkt wel dat zijn applicatie ineens veel sneller is geworden.

Poel van capaciteit

Dit beperkt zich niet tot één server. We kunnen op deze manier een poel van serverhardware creëren die bestaat uit tientallen of desnoods honderden serverapparaten. De visualisatiesoftware schermt de feitelijke hardware geheel af en heeft de beschikking over de optelsom van al die servercapaciteit. De virtualisatiesoftware kan deze vervolgens op basis van vrijwel iedere gewenste specificatie toewijzen aan virtual machine en daarmee aan applicaties.

Zo werkt het ook met storage en networking. We creëren een enorme hoeveelheid opslagcapaciteit door honderden of duizenden hard disks softwarematig aan elkaar te koppelen. Hierdoor ontstaat een poel aan opslagcapaciteit. Deze capaciteit kan vervolgens in door de IT-afdeling vast te stellen hoeveelheden aan applicaties of servers beschikbaar worden gesteld. Dreigt de hoeveelheid virtuele storage vol te raken, dan kunnen we de aan een applicatie toegewezen hoeveelheid simpelweg softwarematig vergroten.

Hetzelfde fenomeen kunnen we toepassen op networking. Eenvoudig gesteld: de fysieke kabel is niet langer bepalend voor de dataverbinding. De beschikbare bandbreedte wordt in een softwarematige poel gebundeld en kan afhankelijk van de eisen en wensen van de IT-afdeling in op maat gemaakte stukjes connectiviteit beschikbaar worden gesteld aan servers, storage of applicaties.

Gevraagd: automatisering

Dit toewijzen kan handmatig gebeuren, maar in de praktijk is dit veel te omslachtig. Aan de hand van duidelijke afspraken kan dit echter prima geautomatiseerd worden. Denk hierbij bijvoorbeeld aan zogeheten ‘regels’ (rules) die stellen dat een specifieke applicatie altijd een bepaalde responsietijd dient te kennen. Of dat nooit meer dan een bepaald percentage van de toegewezen storagecapaciteit daadwerkelijk in gebruik mag zijn. Wordt dat percentage storage overschreden, dan wordt automatisch extra opslagcapaciteit beschikbaar gesteld. Dit wordt dan tevens in de administratie van de IT-afdeling bijgewerkt, zodat men precies weet welke applicatie welke hoeveelheid storage in gebruik heeft. Op die manier kan bijvoorbeeld ook het gebruik van IT altijd op een correcte wijze financieel aan de gebruikers binnen de business-organisatie worden doorbelast.

Een SDDC is niet nieuw. De technologie is al geruime tijd beschikbaar. De grote hyperscale datacenters en bijvoorbeeld grote banken passen deze aanpak al langer toe. In de meeste middelgrote en kleinere datacenters zien we echter dat men pas sinds kort met SDDC aan de slag is.

Dit heeft een behoorlijke impact op de infralaag van het datacenter. Bij de hyperscalers zagen we al dat de scheiding tussen facilitair en IT-personeel vrijwel volledig is verdwenen. Bij iedere beslissing die men neemt, kijkt men naar de impact op het gehele datacenter. Netwerk engineers hebben daardoor ineens belangstelling voor power en koelspecialisten denken mee hoe een aanpassing in hun installatie de beschikbaarheid van een applicatie kan verbeteren.

Geïntegreerd datacenterbeheer

De scheiding tussen de IT-laag en de infralaag valt dus weg. Ook als het om het beheer van het datacenter gaat. De scheiding tussen IT asset management en DCIM (datacenter infrastructure management) verdwijnt daarmee dus ook. Het datacenter dient als één geheel te worden beheerd. Het is immers niets meer - maar zeker ook niet minder - dan de leverancier van een enorme poel aan IT-capaciteit: compute, storage en networking. Daarmee ondersteunt de IT-afdeling de applicaties die de business nodig heeft voor zijn dagelijkse operatie en processen.

Vanuit de business komen continu verzoeken voor aanpassingen in de beschikbaar gestelde datacentercapaciteit. Vaak wil men meer, maar soms ook minder. Denk maar eens aan een bedrijf dat rond de Olympische Spelen een grote marketingcampagne gericht op consumenten doet. Iedereen kan een prijs winnen, maar dan moet men wel - bijvoorbeeld - een leuke foto of video uploaden naar de website van dit bedrijf. Hoe succesvoller die campagne, hoe meer datacentercapaciteit men dus nodig heeft. Maar is die marketingcampagne eenmaal weer voorbij, dan wordt de voor dit project benodigde hoeveelheid datacentercapaciteit weer fors teruggebracht.

In andere situaties zal de business regelmatig kleine aanpassingen nodig hebben. Die kunnen we prima langs geautomatiseerde weg realiseren op basis van regels, zoals genoemd in het eenvoudige voorbeeld dat hiervoor is behandeld. Maar dat betekent wel dat het beheer van het gehele datacenter ook geautomatiseerd dient te zijn. Want als de business aanpassingen nodig heeft op het gebied van bijvoorbeeld connectiviteit, dan dient ook de hoeveelheid energie die de daarvoor benodigde extra Cisco- of Juniper-switches nodig hebben naar de juiste zalen en de juiste racks gebracht te worden. Ook de capaciteit om de geproduceerde warmte af te voeren, dient automatisch aangepast te kunnen worden.

Met andere woorden: een geautomatiseerde virtualisatie van compute, storage en networking vereist ook een geautomatiseerd beheer van de IT-laag én de fysieke infrastructuur in het datacenter.

Robbert Hoeffnagel, Hoofdredacteur DatacenterWorks